Présentation

La première partie du cours est construite autour de la chaîne de traitement du signal audio pour la voix et la musique. On parlera de psychoacoustique (dynamique de l’oreille, masquage), d’acoustique musicale (gammes, synthèse sonore) , de compression MP3 et d’illusions sonores, et des effets de traitement audio les plus courants dans les systèmes audio professionnels (post-prod cinéma et production musicale, radio, TV, robotique, jeu video), en particulier l’égalisation, la compression dynamique, la spatialisation et la réverbération.

Une seconde partie porte sur les aspects architecture pour le traitement audio : CODEC audio, DSP, STM32, interfaces I2S, SAI, SPDIF, etc

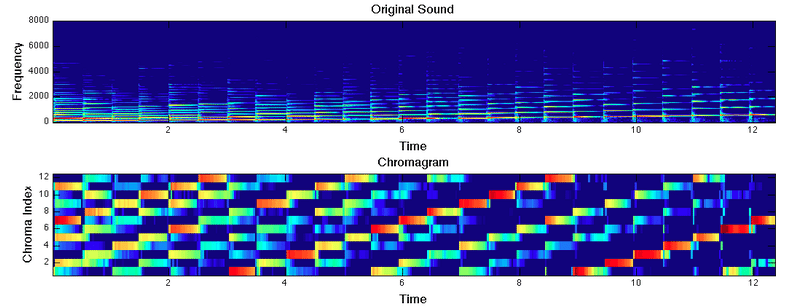

Une troisième et dernière partie est consacrée au traitement du signal audio pour la MIR (Music Information Retrieval) : indexation et classification, séparation de sources, machine learning et inférence bayésienne.

Enfin, les sujets de TP prolongent le cours plus qu’ils ne l’illustrent : il s’agit davantage d’un espace d’exploration et de réflexion autour du traitement du signal audio via l’étude d’une ou deux problématiques particulières sur plusieurs séances selon les années.

Supports de cours

- Première partie (rappels d’acoustique, psychoacoustique, chaîne analogique, chaîne numérique, architectures) – S. Reynal, ETIS CNRS

- Séparation de sources appliquée à la musique (R. Hennequin, Deezer)

- Transformation et séparation du son (G. Peeters, IRCAM)

- Modèles de signaux, estimateurs, descripteurs audio et apprentissage machine (G. Peeters, IRCAM)

- Non-Negative Matrix Factorization pour la séparation de source : calcul détaillé (Dogac Basaran, Audible Magic, UK)

- Deep learning pour la classification de morceaux de musique (R. Hennequin)

Travaux Pratiques

16h de “TP/mini-projet” permettent d’explorer le thème du traitement audio temps réel sur plateforme STM32F746-Discovery.

- une présentation générale de la thématique avec des pistes d’exploration : https://www.overleaf.com/read/tccnxpvjnsmm

- un fichier ZIP contenant le projet STM32CubeIDE offrant un point de départ fonctionnel